Wörterbücher

Release 1.7.1

HTR benötigt keine Wörterbücher. Dennoch gibt es sie auch hier und sie können wahlweise zugeschaltet werden, wenn man eine Volltexterkennung durchführt.

Bei jedem HTR-Training, kann aus dem GT im Trainingsset ein Wörterbuch generiert werden, in dem auch die Häufigkeit, mit der ein Wort vorkam, hinterlegt ist. Es ist also möglich, ein passendes Wörterbuch für jedes Modell bzw. für die Textart mit der man arbeitet zu erzeugen.

Insgesamt werden Wörterbücher in Transkribus aber selten benutzt. In unserem Projekt werden sie nur zu Beginn der Arbeit an neuen Modellen eingesetzt. So lange das Modell, das verbessert werden soll noch eine CER von mehr als 8% aufweist, ist nämlich das Korrigieren der von der HTR erkannten Texte sehr aufwendig. Setzt man an dieser Stelle ein Wörterbuch ein, lässt sich die CER manchmal bis auf 5% senken. Hat das Modell bereits eine CER unter 8%, ist der Einsatz von Wörterbüchern kontraproduktiv, weil sich das Leseergebnis dann häufig wieder verschlechtert. Die HTR ersetzt dann manchmal „wider besseres Wissen“ ihr eigenes Leseergebnis gegen eine Empfehlung, die sich aus dem Wörterbuch ergibt.

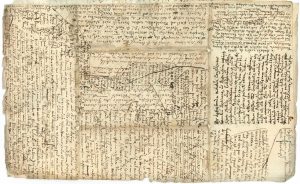

Wir setzen Wörterbücher nur zur Unterstützung von sehr schwachen Modellen ein. Und wir tun das auch eher, um den Transcriber bei besonders schwierigen Schriften eine Hilfestellung zu geben. So haben wir ein Wörterbuch bei der Erstellung des GT für die wirklich kaum lesbaren Konzeptschriften eingesetzt. Die Ergebnisse mussten natürlich in jedem Fall korrigiert werden. Aber die „Leseempfehlungen“ die aufgrund der HTR mit Wörterbuch entstanden, waren eine gute Hilfe. Sobald unser Modell in der Lage war, auch Konzeptschriften mit unter 8% CER zu erkennen, haben wir auf den Einsatz des Wörterbuches verzichtet.