Ein technischer Parameter, der zu Beginn des Scanprozesses einheitlich festgelegt werden muss, ist die Auflösung der Digitalisate, d.h. wie viele Bildpunkte/dots per inch (dpi) das gescannte Bild aufweist.

Die DFG-Praxisregeln zur Digitalisierung empfehlen allgemein 300 dpi (S. 15). Für „Textdokumente mit dem kleinsten signifikanten Zeichen“ von bis zu 1,5 mm kann jedoch eine Auflösung von 400 dpi gewählt werden (S. 22). Tatsächlich können bei den Handschriften – insbesondere den Konzeptschriften – der frühen Neuzeit kleinste Zeichenbestandteile unterschiedliche Lesarten zur Folge haben und sollten also möglichst eindeutig zu erkennen sein. Wir haben uns daher für 400 dpi entschieden.

Neben den Vorteilen für das Entziffern der Schriften muss aber gleichzeitig auch das deutlich größere Speicherformat der 400er (rund 40.000 KB/img.) gegenüber den 300er (rund 30.000 KB/img.) Dateien bedacht und eingeplant werden!

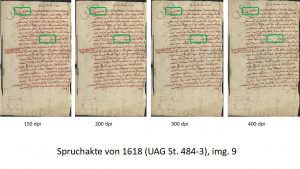

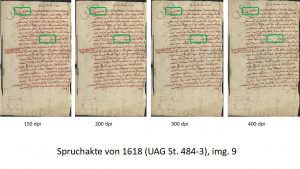

Die gewählte dpi-Zahl hat darüber hinaus auch Auswirkungen auf den Prozess der automatischen Handschriftenerkennung. Unterschiedliche Auflösungen bringen unterschiedliche Ergebnisse der Layout Analyse und der HTR mit sich. Zur Überprüfung dieser These haben wir etwas willkürlich drei Seiten aus einer Spruchakte von 1618 ausgewählt, diese jeweils in 150, 200, 300 und 400 dpi gescannt, sämtliche Seiten in Transkribus bearbeitet und folgende CERs ermittelt:

| Seite/dpi |

150 |

200 |

300 |

400 |

| 2 |

3,99 |

3,5 |

3,63 |

3,14 |

| 5 |

2,1 |

2,37 |

2,45 |

2,11 |

| 9 |

6,73 |

6,81 |

6,52 |

6,37 |

Grob gesagt bedeutet eine geringere Auflösung also eine Verschlechterung der CER – wenn auch im Rahmen von unter einem Prozent.

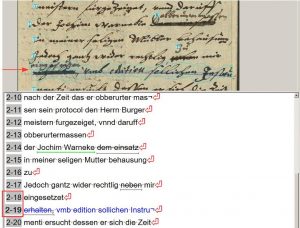

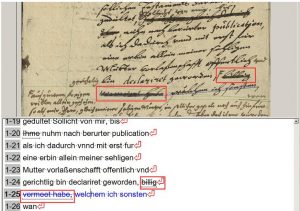

Ehrlich gesagt, hinken solche Vergleiche der HTR-Ergebnisse aber. Schon die Grundlage der HTR – die Layout Analyse – kommt nämlich bei unterschiedlichen Auflösungen zu latent unterschiedlichen Ergebnissen die im Resultat dann die HTR-Ergebnisse (scheinbar gröbere Analysen erzielen schlechtere HTR-Ergebnisse) aber auch die GT-Produktion selbst beeinflusst (z.B. bei abgeschnittenen Wortbestandteilen).

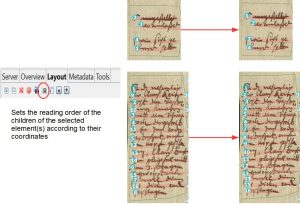

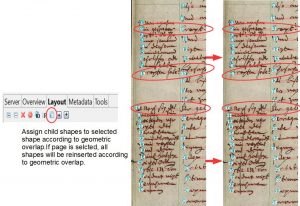

In unserem Beispiel seht ihr dasselbe image in unterschiedlicher Auflösung. Hier verändert sich das Ergebnis der CITlab Advanced LA mit fortschreitend erhöhter Auflösung. Das initiale „V“ der ersten Zeile wird bei höherer Auflösung nicht mehr erkannt, während Zeile 10 bei höherer Auflösung zunehmend „auseinandergerissen wird“. Mit zunehmender Auflösung wird die LA sensibler – das kann Vor- und Nachteile zugleich haben.

Wichtig ist daher in erster Linie eine für das gesamte Projekt einheitliche dpi-Zahl, damit die durchschnittlichen CER-Werte sowie das gesamte statistische Material belastbar bleiben.