Ground Truth ist das A und O

Release 1.7.1

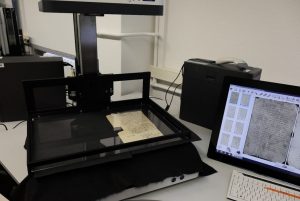

Die Grundlage für die Erstellung von HTR-Modellen ist der sogenannte Ground Truth (GT). Das ist erst einmal nichts weiter als eine maschinenlesbare Abschrift der historischen Handschrift, eine klassische litterale oder diplomatische Transkription, die zu 100% korrekt ist – „Groundt Truth“ eben.

Jeder Fehler in diesem Trainingsmaterial sorgt dafür, dass „die Maschine“ (neben vielem Richtigen) etwas Falsches lernt. Darum ist Qualitätsmanagement bei der Erstellung von GT so wichtig. Aber keine Panik, nicht jeder Fehler im GT hat verheerende Folgen, er darf sich nur nicht allzu oft wiederholen, sonst wird er für das Modell „chronisch“.

Um die Qualität des GT innerhalb unseres Projektes zu sichern, haben wir ein paar feste Transskriptionsrichtlinien aufgestellt, wie man sie auch aus Editionsprojekten kennt. Es lohnt sich, dabei von einer litteralen, zeichengenauen Transkription auszugehen. Auf Regulierungen jeder Art, auf Normalisierungen, etwa bei der vokalischen oder konsonantischen Verwendung von „u“ und „v“ muss dabei ebenso verzichtet werden, wie auf die Auflösung komplexer Abbreviaturen.

Wenn das Material nur ein oder zwei unterschiedliche Handschriften oder Schreiberhände enthält, genügen um die 100 Seiten transkribierter Text für ein erstes Training, um ein Basismodell zu erstellen, mit dem man weiterarbeiten kann. Die Anzahl der im Text verwendeten Sprachen spielt dabei übrigens nach unseren Erfahrungen keine Rolle, denn die HTR-Modelle arbeiten im Regelfall ohne Wörterbücher.

Neben der herkömmlichen Transkription kann Ground Truth auch halbautomatisiert erstellt werden. Dazu bietet Transkribus ein spezielles Tool- Text2Image – das in einem anderen post vorgestellt wird.